本站5月16日消息,今天騰訊正式發(fā)布了業(yè)內(nèi)首個(gè)毫秒級(jí)響應(yīng)的實(shí)時(shí)生圖大模型——混元圖像2.0(Hunyuan Image2.0)。

目前已經(jīng)在騰訊混元官方網(wǎng)站上線,并對(duì)外開(kāi)放注冊(cè)體驗(yàn),該模型主要有兩大特點(diǎn):實(shí)時(shí)生圖、超寫(xiě)實(shí)畫(huà)質(zhì)。

相比前代模型,騰訊混元圖像2.0模型參數(shù)量提升了一個(gè)數(shù)量級(jí),得益于超高壓縮倍率的圖像編解碼器以及全新擴(kuò)散架構(gòu),其生圖速度顯著快于行業(yè)領(lǐng)先模型。

在同類(lèi)商業(yè)產(chǎn)品每張圖推理速度需要5到10秒的情況下,騰訊混元可實(shí)現(xiàn)毫秒級(jí)響應(yīng),支持用戶可以一邊打字或者一邊說(shuō)話一邊出圖,改變了傳統(tǒng)“抽卡—等待—抽卡”的方式。

除了速度快以外,騰訊混元圖像2.0模型圖像生成質(zhì)量提升明顯,通過(guò)強(qiáng)化學(xué)習(xí)等算法以及引入大量人類(lèi)美學(xué)知識(shí)對(duì)齊,生成的圖像可有效避免AIGC圖像中的“AI味”,真實(shí)感強(qiáng)、細(xì)節(jié)豐富、可用性高。

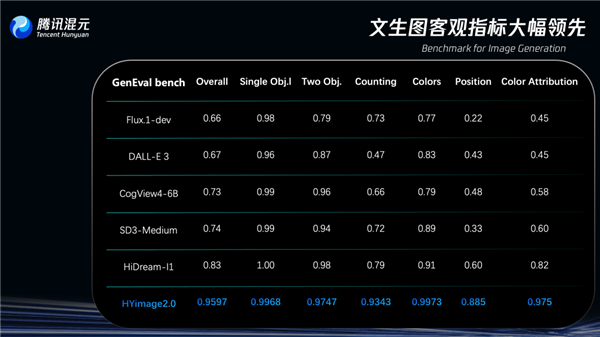

在圖像生成領(lǐng)域?qū)iT(mén)測(cè)試模型復(fù)雜文本指令理解與生成能力的評(píng)估基準(zhǔn)GenEval(Geneval Bench)上,騰訊混元圖像2.0模型準(zhǔn)確率超過(guò)95%,遠(yuǎn)超其他同類(lèi)模型。

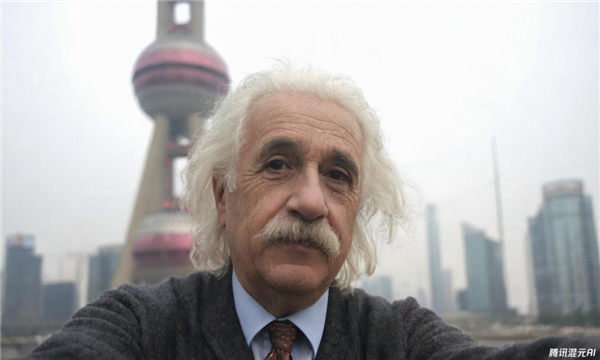

提示詞:人像攝影,愛(ài)因斯坦,背景是東方明珠,自拍視角

騰訊表示,騰訊混元圖像2.0引入多模態(tài)大語(yǔ)言模型(MLLM)作為文本編碼器,配合自研的結(jié)構(gòu)化caption系統(tǒng),不僅能理解你在說(shuō)什么,更能推測(cè)出你希望畫(huà)面「怎么表達(dá)」。

哪怕你一句話里埋了三層含義,它也能一一拆解,再一筆一筆畫(huà)出來(lái)。

除了文字輸入,騰訊混元圖像2.0還可以通過(guò)語(yǔ)音直接輸入提示詞,系統(tǒng)將語(yǔ)音自動(dòng)轉(zhuǎn)寫(xiě)為文字,并在識(shí)別后即時(shí)生成圖像,適用于直播講解、移動(dòng)創(chuàng)作等場(chǎng)景。

也可以上傳草圖作為參考,模型能自動(dòng)識(shí)別線稿的結(jié)構(gòu)與構(gòu)圖邏輯,再結(jié)合提示詞內(nèi)容補(bǔ)全光影、材質(zhì)、背景等細(xì)節(jié),迅速擴(kuò)展成圖。

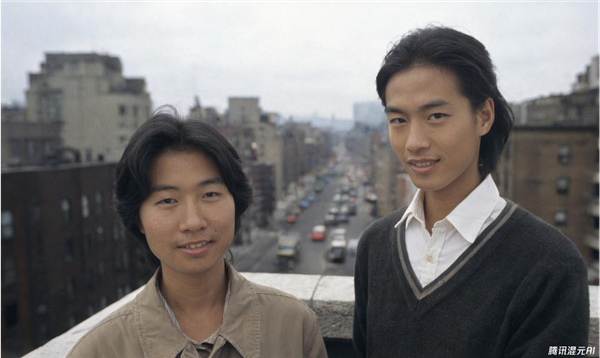

騰訊混元圖像2.0模型生成的圖片:

人像攝影風(fēng)格

動(dòng)物特寫(xiě)

復(fù)古攝影

動(dòng)漫風(fēng)格

真實(shí)人物風(fēng)格

鄭重聲明:本文版權(quán)歸原作者所有,轉(zhuǎn)載文章僅為傳播更多信息之目的,如作者信息標(biāo)記有誤,請(qǐng)第一時(shí)間聯(lián)系我們修改或刪除,多謝。